This group contains cookies that are necessary for our websites to work. They take part in functionalities like language preferences, traffic distribution or keeping user session. They cannot be disabled.

| Cookie name

|

Description

|

|---|---|

| SERVERID | |

| userBranchSymbol | Expiration date 1 day |

| test_cookie | Expiration date 1 hour |

| adobe_unique_id | Expiration date 364 days |

| __hssc | Expiration date 1 hour |

| SESSID | Expiration date 1 day |

| __cf_bm | Expiration date 1 hour |

| intercom-id-iojaybix | Expiration date 270 days |

| intercom-session-iojaybix | Expiration date 6 days |

| xtbCookiesSettings | Expiration date 364 days |

| TS5b68a4e1027 | |

| countryIsoCode | |

| xtbLanguageSettings | Expiration date 364 days |

| userPreviousBranchSymbol | Expiration date 364 days |

| intercom-device-id-iojaybix | Expiration date 270 days |

| __cfruid | |

| _cfuvid |

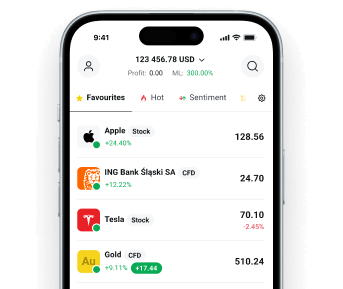

Stocks

Stocks

ETFs

ETFs

Indices CFD

Indices CFD

Forex CFD

Forex CFD

Commodities CFD

Commodities CFD